Sonu veri hikayeciliğine çıkan yolun kronolojik bir incelemesi ve operasyonel tanımın tartışılması üzerine bir not…

Güçlü bir fikir, kesinlikle büyüleyicidir. Ancak o fikri kullanmaya karar verene kadar kesinlikle işe yaramazdır. Richard Bach

“Büyük Veri” ve “Veri ile Karar Veren Kurumlar” gibi kavramlar “Dijital Dönüşüm” sürecinin merkezinde, neredeyse 15 yıldır gündemde. Veri işleme ve depolamada çığır açan teknolojilerin 2010’lu yılların ikinci yarısından itibaren yaygınlaşmasıyla, veriden içgörü çıkarma (veri analizi) iş hayatında tabana yayılan bir konsept oldu. Bir kaç sene içerisinde Genel Müdürden, iş birimi fonksiyonlarının uzmanlarına kadar herkes “Veri Analisti” rolünü üstlenmek zorunda kaldı.

Bu süreç iş hayatının veri ile karar verme kültürü odağında evrilmesine neden oluyor. Ancak her kökten dönüşümde olduğu gibi, veri odaklı dönüşümde de yeni teknolojilerin kendisi, hangi ihtiyaçtan dolayı bu yolda büyük bir adım atıldığının ve teknolojilerin geliştirildiği çözümlemesinin önünde kaldı.

Çok büyük verinin etkin olarak dağıtılması ve kesintisiz işlenmesinin sağlanması sistem mimarlarının birinci önceliği idi. Bu nedenle bu büyük dönüşüm yolculuğu sırasında kilit bir sorunun cevabı genelde hiç düşünülmedi ya da iş biriminin veri analiz ihtiyaçları şeklinde hızla atlandı;

Veri odaklı kararı kim alacak? Bu kişinin bu kararı alırken içgörüye odaklanmasını nasıl kolaylaştırabiliriz? Veri odaklı karar alma ile ilgili karar alma noktalarının yetkinlikleri nasıl planlanmalı.

Bu sorular özellikle BT yöneticilerin dijital dönüşüm alanında daha aşina olduğu teknoloji merkezli sorunlardan, farklı olarak çözüm metodolojisinin geliştirilmesi merkezli sorunları gündeme getirdi. “Büyük Verinin” saklanması ve etkin olarak işlenmesi için gerekli teknoloji hızla gelişirken, sürecin son aşaması için bir çözüm ihtiyacı doğdu. Veri işleme sürecinin en sonunda yer alan “Veri Analizi” aşamasında dev veri silolarında saklanan verilerin nasıl toplulaştırılacağı ve temsil gücü yüksek metriklere (KPI) dönüştürüleceği. Ve nihayet, nasıl somut içgörü haline getirileceği en kritik sorun olarak ön plana çıktı.

Yazının gelişinden anladığınız gibi, “Bilgisayar Bilimi” verinin analistlerin önüne getirilmesi tarafında üzerine düşen görevi yerine getirmiştir. Ancak 20.yy’nin başında formüle olmuş geleneksel istatistik bilimi verinin özetlenmesi ve karar birimlerine sunulması aşamasında yetersiz kalmaktaydı.

İngilizcede Exploratory Data Analysis (EDA) olarak geçen “Keşifsel Veri Analizi” geleneksel istatistiksel çıkarım tekniklerine bir tepki olarak doğdu. O dönemde hakim olan geleneksel yöntemler “Doğrulayıcı Veri Analizi”, (Confirmatory Analysis) olarak adlandırılabilir. Bu yaklaşım, veriden çıkarım yapmayı, hipotezlerin test edilmesi odaklı bir analiz süreci olarak ele almakta idi. Oysa “Keşifsel Veri Analizi”, veri odaklı idi.

John Tukey’in 1968’den itibaren Princeton Üniversitesi İstatistik Bölümü’nde verdiği derslerin birikimi, 1977’de yayımlanan Exploratory Data Analysis (Keşifsel Veri Analizi) kitabında toplandı; bu kitap, keşifsel yaklaşımın istatistiksel çıkarım içindeki yerini kuramsal olarak temellendirdi.

1930’lardan itibaren hakim olan “Confirmatory Analysis” in tersine “Keşifsel Veri Analizi” istatistikçilerin teknik dilini kullanmıyordu. Analiz sırasında ortalama, medyan, standart sapma gibi tüm veri yığınını temsil gücü yüksek metrikler (KPI) hesaplanıyordu. Daha sonra, bu metrikler kullanılarak temsil gücü yüksek çizimler ile yöneticinin ya da karar alıcının içgörü üretmesi hedefleniyordu. Artık veri “modelleme” içerisinde bir girdi değildi, “çıkarım süreci” içerisinde aktif bir öğe idi.

İşte “Veri Hikayeciliği” istatistiksel çıkarım sürecinin bu tarihsel dönüşümü sürecinde 2000’li yılların başında gündeme gelmeye başladı. Her ne kadar “Keşifsel Veri Analizi” veri odaklı karar vermeyi istatistikçiler ve analistlerin tekelinden çıkarmış olsada, kurumlarda veri iki ayrıcalıklı grubun tekelinde kalmaya devam etmekteydi.

Bunlar işi yönetmesi için veriye ihtiyaç duyan üst düzey yöneticiler ve onlara sayfalarca ortalama ve oynaklık verisinin bulunduğu excel dosyaları hazırlayan veri uzmanlarıydı. Bu gruplar dışında kalan kişilerin veriye erişimi sınırlı ve genelde düzenli bir akışta olmuyordu.

Günümüzün dinamik iş ortamı iki önemli konuda kurumları zorlamakta. Bunlardan birincisi böyle bir rekabet ortamında verinin sadece bir kaç tepe yöneticinin erişebildiği bir yerde bulunması. Bu durum kurum içi yenilikçiliği ciddi anlamda sınırlayarak rekabet gücünü düşürmekte. Buna ek olarak iş hayatının artan karmaşıklığına bağlı olarak, üst yönetimin çapraz tablolardaki ortalama rakamlarını kafasında somutlaştırarak karar alma sürecine sokma sürecindeki yükünün hafifletilmesi gerekiyor.

2010’lu yıllarda yaşanan bu veri krizi, verinin iletişimi ve paylaşımının daha efektif olarak yapılması gereğini gözler önüne serdi. İşte bu noktada “Veri Okuryazarlığı” yeni dönemin en önemli yetkinliklerinden biri olarak ön plana çıktı. Ama veri okuryazarları veriyi sayfalarca ortalama ile dolu raporlardan mı okuyacaklardı? Bu yükün karar alıcının üzerine atılması doğru mu idi? Verinin sindirilerek, karara dönüştürülmesi sürecine bir kolaylaştırıcı yöntem bulunmalı idi.

Nasıl İngilizceye hakim olmak için İngiliz Dili ve Edebiyatı bölümü mezunu olmanız gerekmiyor ise, veri okuryazarı olmak için de ileri istatistik tekniklerine hakim olmanız gerekmiyor…

“Veri Hikayeciliği” konsepti bu süreç içerisinde ortaya çıktı. Veriden içgörü çıkarma sürecini zahmetsiz ve doğal bir algı sürecine dönüştürmek ve karar vericilerin yükünü azaltmak için bu konseptin yöntemleri iş hayatında yoğun olarak kullanılmaya başlandı.

Psikolog Gary Klein, “Başkalarının göremediğini görmek…” isimli kitabında (linkten ulaşılabilir) içgörü için sezgi kavramından yola çıkarak bir tanım oluşturuyor. Sezgi, kişinin zaten öğrenmiş olduğu örüntüleri kullanmasıdır; içgörü ise yeni örüntülerin keşfedilmesidir.

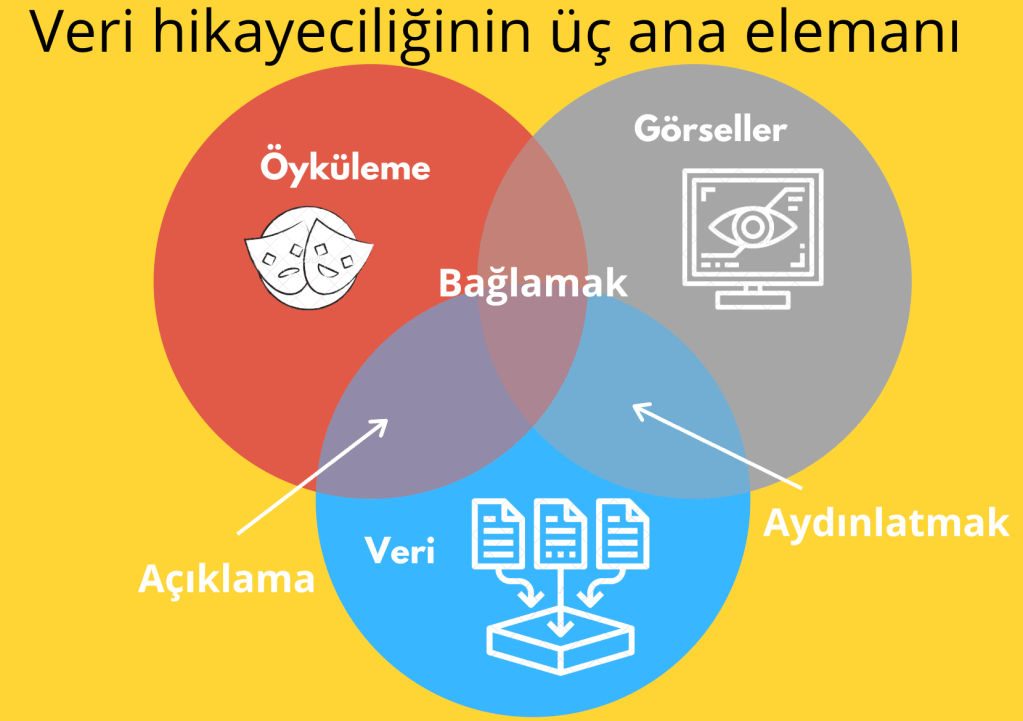

Veri hikayeciliği üç ana elemanın başarılı bir şekilde kombinasyonundan oluşur.

- Veri

- Öykü

- Görsel

Dilerseniz bugünkü yazımızın sonlarına yaklaşırken, “Veri Hikayeciliği” tekniklerinin öncüsü Brent Dykes, “Effective Data Storytelling” isimli kitabında bu üç öğenin nasıl harmanlanarak içgörü yaratılabileceği yönündeki süreç önerisini tartışalım.

“Öykü ve Veri” elemanları, birleştiğinde hedef kitlenize verinin içerisinde neyin gerçekleştiğini ve altını çizdiğiniz kavrayışların neden önemli olduğunu açıklamış olursunuz. Öte yandan, “Görsel ve Veri” elemanları, birleştiğinde hedef kitlenizi grafikler ve tablolar dışında yakalanması mümkün olmayan kavrayışlar konusunda aydınlatmış olursunuz.

Son aşamada, “Görsel ve Öykü” elemanları, birleştiğinde veri hikayeniz ile hedef kitlenizi konuya bağlama, hatta anlattığınız hikayeden keyif almasını sağlama imkanınız olur.

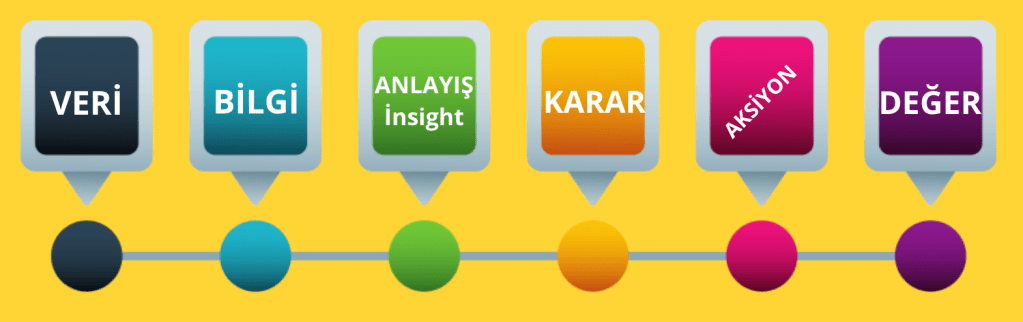

Temel mekanizması yukarıdaki şekilde formüle edilebilecek “Veri Hikayeciliği”, “Analitik Değer Yaratma” yolunun üzerinde “Anlayış” / “İçgörü” basamağının geçilmesi için önerilen yöntemler bütünüdür.

Bu yazıda, “Veri Bilimcileri”, (evet veri bilimciler sadece dev karar ağaçları ve karmaşık derin öğrenme sistemleri tasarlamıyor…) “Veri Hikayeciliği” süreçlerini geliştirmeye zorlayan süreci ve ilk aşamada “Veri Hikayeciliğin” operasyonel tanımı ve ana bileşenlerini sizlere aktarmaya çalıştım. Bu serinin bir sonraki aşamasında “Psikoloji” ve “Veri Analizi” arasındaki bağlantıyı inceleyerek hacimli veriler üzerine insanların nasıl zahmetsiz bir şekilde içgörü üretebileceği üzerinde duracağız.

Leave a comment